Dans un univers numérique où chaque clic compte, l’A/B testing s’impose comme la méthode incontournable pour valider vos choix et améliorer votre performance en ligne. Issue des laboratoires de data science, cette approche se démocratise désormais auprès des TPE, PME et e-commerçants désireux de prendre des décisions pragmatiques. Les managers marketing et les responsables de site web adoptent progressivement cette démarche scientifique pour optimiser leur expérience utilisateur et augmenter leur taux de conversion.

Au cœur de cette méthode : l’expérimentation contrôlée. Plutôt que de laisser place à l’intuition, on confronte directement deux versions d’un même élément pour mesurer leur impact. Résultat ? Des décisions basées sur des chiffres, pas sur des suppositions.

Grâce à l’A/B testing, il devient possible de tester un bouton d’appel à l’action, une offre promotionnelle, la longueur d’un formulaire ou même la couleur d’un visuel. La victoire du plus efficace s’exprime en pourcentage de clics, de ventes ou de leads générés.

Envie de comprendre comment implémenter cette méthode et quels outils choisir ? Les sections qui suivent vous guideront pas à pas, illustrées par des exemples concrets et des études de cas adaptées à vos enjeux 2025.

Comprendre l’A/B testing : définition, principes et enjeux

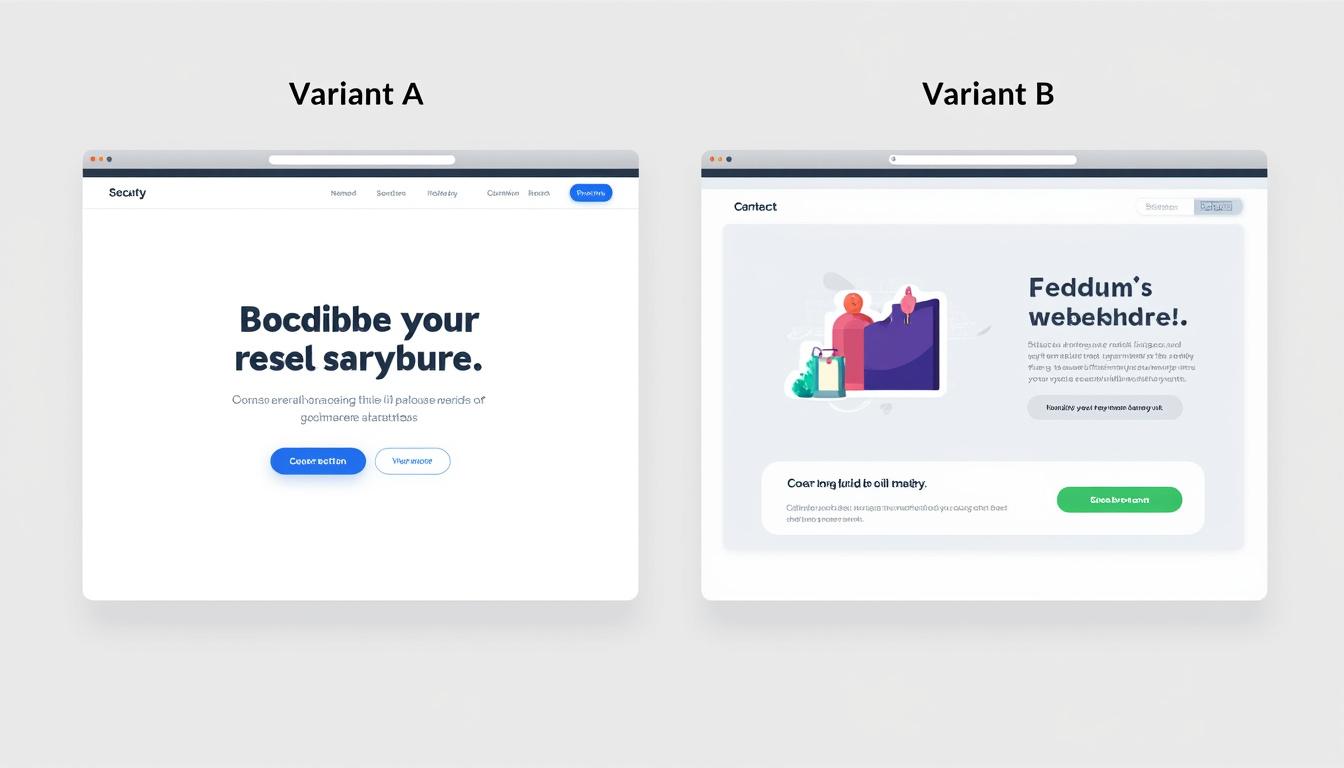

La première étape consiste à déchiffrer ce que recouvre réellement le terme « A/B testing ». Derrière cette appellation, souvent qualifiée de « split testing », se cache une méthodologie rigoureuse destinée à comparer deux variantes (A et B) d’un même élément digital. L’objectif : identifier celle qui génère le meilleur retour sur investissement ou le plus fort engagement.

Cette démarche repose sur un protocole imposé :

- Formulation d’une hypothèse : Définir l’élément (titre, image, bouton, offre) que l’on considère susceptible d’influencer une métrique clé.

- Conception de deux versions : La version A (contrôle) et la version B (variante) ne diffèrent que sur un seul critère mesurable.

- Répartition aléatoire : Un outil comme Google Optimize ou Optimizely garantit que chaque visiteur appartient à l’un des deux groupes, sans biais.

- Collecte et analyse des données : On mesure le taux de conversion, le taux de clic, le temps passé, etc., pour départager A et B.

En plaçant l’expérience utilisateur au centre du processus, l’A/B testing permet aussi de réduire les risques liés aux décisions marketing. Avant de lancer une nouvelle campagne sur toute votre clientèle, mieux vaut vérifier son efficacité sur un échantillon.

| Étape | But | Outil recommandé |

|---|---|---|

| Définir l’hypothèse | Clarifier l’objectif | Notion, Trello |

| Construire la variante | Tester un changement précis | Unbounce, Instapage |

| Lancement du test | Répartition aléatoire | VWO, Kameleoon |

| Analyse des résultats | Choisir la version gagnante | Crazy Egg, Convert |

Pourquoi l’A/B testing séduit autant de PME et e-commerçants ?

Vous vous demandez comment dépasser la simple optimisation SEO et générer de la croissance concrète ? L’A/B testing répond à cette question : il transforme chaque clic en opportunité de compréhension, chaque formulaire incomplet en enseignement. En 2025, 77 % des entreprises de taille moyenne ont déjà intégré cette pratique dans leur ADN stratégique.

- Empreinte data-first : Fini les choix basés sur le feeling, place aux insights.

- Déploiement progressif : Testez sur un segment, puis généralisez la version gagnante.

- Effet mesurable : Chaque variation apporte un gain chiffré, visible en temps réel.

Cet éclairage statistique aide à rationaliser les efforts marketing et à maximiser les budgets. Un dernier insight : l’A/B testing n’est pas réservé aux géants du web. Les TPE et commerçants indépendants peuvent y recourir à moindre coût, grâce à des solutions freemium et des outils accessibles. Pour approfondir la définition de cette méthode, consultez la page dédiée sur Référencement Réactif.

Ce protocole fondé sur l’expérimentation constitue le socle d’une stratégie digitale performante et adaptable à tout type d’entreprise.

Mettre en place un A/B test pas à pas sur votre site web

Avant de vous lancer, il est essentiel de structurer votre démarche. Les tests réalisés à la va-vite perdent de leur valeur, et un protocole bâclé risque de conduire à des résultats biaisés. Voici un guide pratique pour cadrer votre expérimentation :

- 1. Choisir un objectif précis : Améliorer la souscription à la newsletter, augmenter le panier moyen, réduire le taux de rebond.

- 2. Sélectionner la métrique clé : Clic sur un CTA, formulaire complété, temps passé sur une page.

- 3. Créer des variantes mesurables : Modifier la couleur d’un bouton, remplacer une image, reformuler un titre.

- 4. Définir la taille d’échantillon : Une centaine de visites par version assure souvent une validité statistique minimale.

- 5. Lancer le test : Grâce à Google Optimize, Adobe Target ou LaunchDarkly, le test démarre en quelques clics.

- 6. Analyser les résultats : Consolidation des données, validation de l’hypothèse, déploiement de la version gagnante.

Pour les détails techniques, n’hésitez pas à consulter ce guide complet proposé par Référencement Réactif. Il vous accompagnera dans chaque étape et vous fera gagner un temps précieux.

| Étape | Actions clés | Durée estimée |

|---|---|---|

| Objectif & KPI | Définir l’hypothèse et l’indicateur | 1h |

| Création de variantes | Design et rédaction | 2 à 4h |

| Paramétrage de l’outil | Configuration du test | 30min |

| Lancement & suivi | Collecte des données | 1 à 2 semaines |

| Analyse finale | Rapport et décision | 2h |

Conseils pour garantir la fiabilité de votre test

Un résultat d’A/B test doit toujours respecter certaines conditions pour être validé :

- Uniformité de trafic : Assurez-vous que chaque groupe reçoit un volume similaire de visiteurs avec des profils comparables.

- Durée suffisante : Laissez le test courir jusqu’à atteindre un seuil de confiance statistique (généralement 95 %).

- Un seul élément modifié : Pour identifier l’impact exact, ne changez qu’un paramètre par test.

Respecter ces bonnes pratiques vous évitera les interprétations erronées. En cas de doute, un outil tiers comme VWO ou Crazy Egg propose des rapports automatiques pour jauger la portée de vos résultats.

La mise en œuvre méthodique de chaque étape assure un apprentissage continu et des optimisations permanentes de votre parcours utilisateur.

Comparatif des outils d’A/B testing pour 2025

Choisir la bonne solution est un enjeu majeur. Entre solutions open source, freemium ou premium, vous devez évaluer le rapport fonctionnalités/coût et la facilité d’usage pour votre équipe. Voici un tour d’horizon des plateformes les plus plébiscitées :

| Outil | Type | Tests multivariés | Plan freemium |

|---|---|---|---|

| Google Optimize | Web | ✓ | ✓ |

| Optimizely | Web & Mobile | ✓ | ✗ |

| VWO | Web & Mobile | ✓ | ✗ |

| Adobe Target | Web | ✓ | ✗ |

| Unbounce | Landing pages | ✗ | ✓ |

| Instapage | Landing pages | ✗ | ✗ |

| Kameleoon | Web & Mobile | ✓ | ✗ |

| Crazy Egg | Heatmaps | ✗ | ✓ |

| Convert | Web | ✓ | ✗ |

| LaunchDarkly | Feature flags | ✓ | ✗ |

- Google Optimize : Idéal pour débuter sans frais, parfaitement intégré à Google Analytics.

- Optimizely : Solution robuste pour les déploiements complexes et tests multivariés.

- VWO : Plateforme complète, privilégie l’analyse comportementale et les heatmaps.

- Adobe Target : Parfait pour les entreprises déjà équipées de la suite Adobe.

- Crazy Egg : Pour comprendre le parcours utilisateur grâce à la cartographie visuelle.

| Critère | Google Optimize | Optimizely | VWO | Adobe Target | Crazy Egg |

|---|

Chaque outil possède ses atouts : un modèle freemium, une intégration native ou des fonctionnalités avancées de segmentation. Le choix dépendra de votre maturité digitale et de votre budget.

Pour approfondir le déploiement d’une solution, consultez notre article sur comment devenir consultant Google Ads, où l’approche data-driven se révèle incontournable.

En comparant ces plateformes, vous disposerez d’un éclairage suffisant pour prendre la décision la plus rationnelle et la plus rentable.

Cas pratiques et retours d’expérience en A/B testing

Pour illustrer la théorie, rien de tel que quelques études de cas concrètes. Voici trois mises en œuvre réussies, adaptées à différents secteurs :

-

SaaS et vidéo explicative

Un éditeur de logiciel lançait un test pour mesurer l’impact d’une vidéo de démonstration sur la page d’accueil. Il a confronté deux versions : l’une avec vidéo et l’autre avec image statique et texte. Le test a révélé une hausse de 20 % du taux d’inscription sans vidéo. Décision : simplifier la page pour maximiser la conversion. -

Formulaire long vs formulaire court

Une entreprise de services financiers comparait un formulaire détaillé à un formulaire minimaliste. Le formulaire court a généré 35 % de leads en plus. Résultat : adoption définitive de la version allégée. -

Email marketing avec ou sans image

Un pure player e-commerce a testé deux campagnes : emails illustrés vs emails textuels. Surprise : les emails sans visuel ont obtenu 22 % de clics supplémentaires. Conséquence : réduction de l’usage d’images pour privilégier le discours.

| Secteur | Variation testée | Gain observé |

|---|---|---|

| SaaS | Vidéo vs image | +20 % inscriptions |

| Finance | Formulaire long vs court | +35 % leads |

| E-commerce | Email avec vs sans image | +22 % clics |

Apprendre de chaque expérience

Ces retours d’expérience montrent que des modifications mineures peuvent avoir un impact majeur. Dans chaque cas, l’A/B testing a permis de :

- Valider des hypothèses sans déployer massivement.

- Optimiser le ROI grâce à des gains chiffrés.

- Améliorer l’engagement en affinant l’offre et l’interface.

Au fil des tests, on affine sa compréhension du comportement utilisateur et on affine progressivement son parcours. L’acquisition de cette expertise par la pratique est un véritable avantage compétitif.

Chaque nouveau test nourrit le suivant, créant ainsi un cercle vertueux d’optimisation continue.

Mesure des performances et intégration SEO de l’A/B testing

Au-delà de l’augmentation immédiate des conversions, l’A/B testing s’inscrit dans une stratégie SEO globale. Les modifications testées – titres, micro-contenus, CTA – influent sur le crawl et la perception des robots Google. Voici comment allier A/B testing et référencement naturel :

- Balise title et méta-description : Une variante de titre optimisée peut augmenter votre taux de clic organique (CTR) et renforcer votre positionnement.

- Structure sémantique : Testez deux versions de sous-titres pour identifier celle qui capte le plus l’attention, tout en respectant les règles HTML.

- Temps de chargement : Comparez deux hébergements ou deux scripts pour réduire votre temps de réponse serveur, facteur pris en compte par Google Page Experience.

- Maillage interne : Une version A peut proposer plus de liens internes qu’une version B pour encourager la découverte de pages clés.

| Type de test | Impact SEO | Métrique à suivre |

|---|---|---|

| Variation de title | CTR organique | Taux de clics |

| Optimisation de Hn | Compréhension sémantique | Position moyenne |

| Réduction JS/CSS | Vitesse de page | Core Web Vitals |

| Maillage interne | Exploration | Nombre de pages indexées |

Pour enrichir votre visibilité YouTube et vos playlists SEO, découvrez nos conseils sur comment obtenir des vues sur YouTube. Cette démarche combinée favorise une présence digitale cohérente.

Analyse statistique et suivi des KPI

La réussite d’un A/B test s’appuie sur une évaluation rigoureuse :

- Significativité : Vérifiez la p-value et la confiance statistique.

- Effet taille : Mesurez l’ampleur des gains, pas seulement leur sens.

- Durée : Assurez-vous d’une période de test représentative (au moins deux cycles de trafic hebdomadaire).

- Segmentation : Analysez vos résultats par device, source de trafic, zone géographique.

Cette approche permet de prévenir les faux positifs et d’adapter votre stratégie SEO à long terme. Un dernier insight : associer A/B testing et SEO garantit une amélioration continue de votre positionnement et de votre expérience utilisateur.

FAQ : Questions fréquentes sur l’A/B testing

Qu’est-ce qu’un A/B test et pourquoi l’adopter ?

Un A/B test consiste à comparer deux versions d’un élément digital (page web, email, landing page) pour déterminer laquelle offre le meilleur résultat. Adopter cette méthode permet de prendre des décisions basées sur des données réelles et non sur l’intuition, ce qui réduit les risques et optimise les performances.

Quels outils choisir pour démarrer en A/B testing ?

Pour débuter sans frais, Google Optimize est une excellente option grâce à sa gratuité et son intégration à Google Analytics. Les solutions payantes comme Optimizely, VWO ou Adobe Target offrent des fonctionnalités avancées (multivariés, segmentations poussées, API). Le choix dépend de votre budget et de la complexité de vos tests.

Combien de temps doit durer un A/B test ?

La durée variera selon votre trafic, mais un test doit couvrir au moins deux cycles de trafic hebdomadaire (7 à 14 jours) pour garantir une validité statistique. L’objectif est d’atteindre un seuil de confiance de 95 % pour valider un effet positif ou négatif.

Peut-on modifier plusieurs éléments simultanément ?

Oui, via des tests multivariés, mais cela nécessite un trafic plus important pour isoler l’impact de chaque modification. Pour une PME avec un trafic limité, il est conseillé de tester un seul élément à la fois afin de simplifier l’analyse et d’obtenir des résultats fiables.

L’A/B testing a-t-il un impact sur le référencement ?

Indirectement, oui. Les variantes testées peuvent influencer le CTR organique, la vitesse de chargement, l’ergonomie et le maillage interne, autant de facteurs pris en compte par Google. L’A/B testing intégré au SEO contribue donc à une optimisation globale de votre site.